2025年2月2日大约 1 分钟

DeepSeek本地部署

为什么使用本地大模型

近日DeepSeek官网过于火爆,时常不回复

本地部署有更高的安全性

本地部署可以绕过一些官方的限制

测试环境

OS: Windows 10 Pro 22H2

CPU: AMD Ryzen 5 5600H (6C12T, Base 3.3GHz / Boost 4.2GHz)

GPU: NVIDIA GeForce RTX 3050 Ti Laptop GPU (4GB GDDR6 VRAM)

RAM: SAMSUNG 16GB DDR4-3200

IDE: LM Studio v0.3.9

部署方法

推荐使用国外网络环境并开启代理工具的TUN模式

下载安装LM Studio客户端

点击跳转修改模型下载目录(推荐)

防止模型大量占用C盘空间

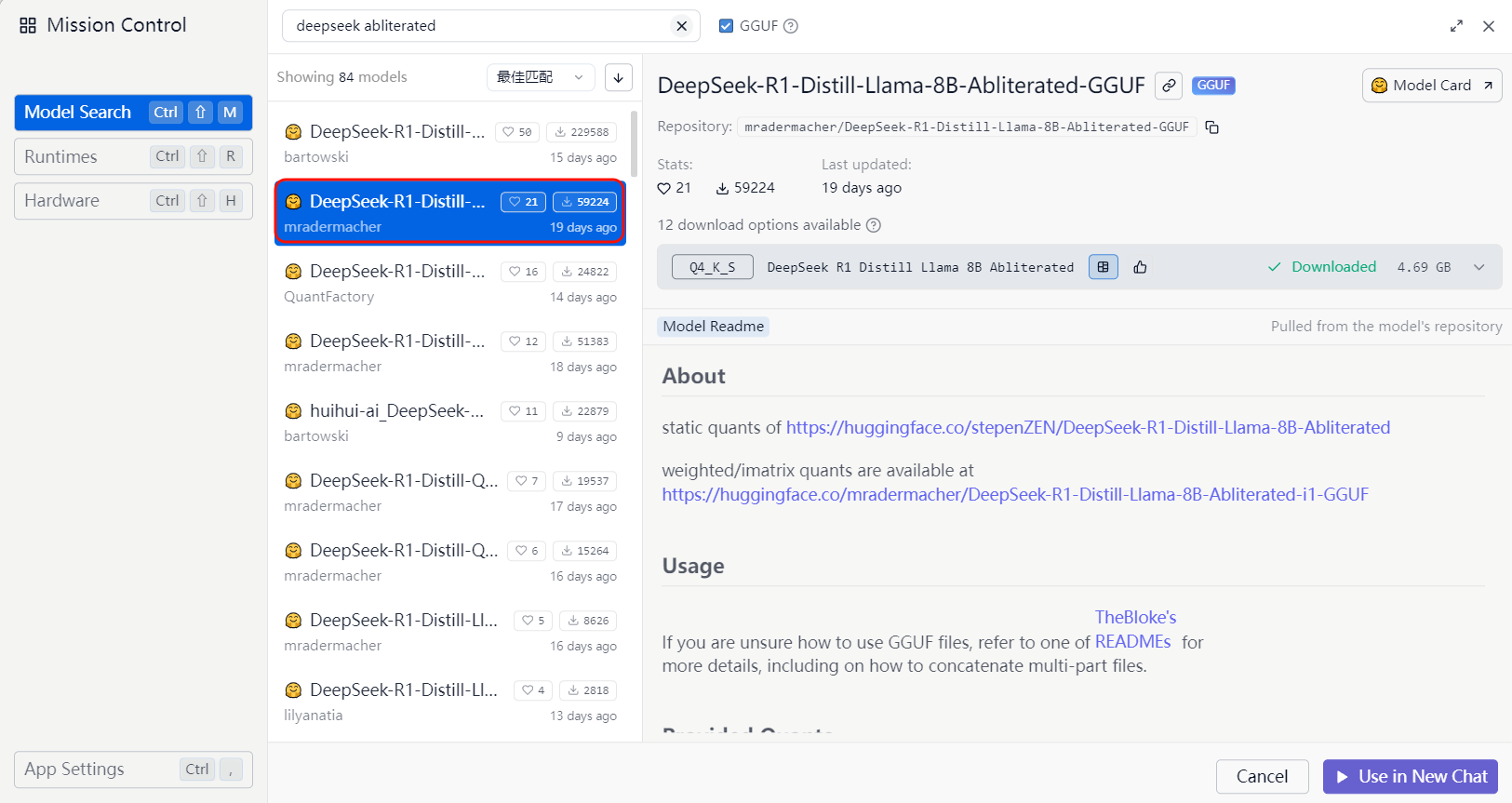

根据电脑配置下载对应模型

带Distill字样的是蒸馏模型

这里推荐DeepSeek-R1-Distill-Llama-8B-Abliterated-GGUF,4g显存能流畅运行,该模型还解除了DeepSeek自带的一些限制,让本地应用更加自由

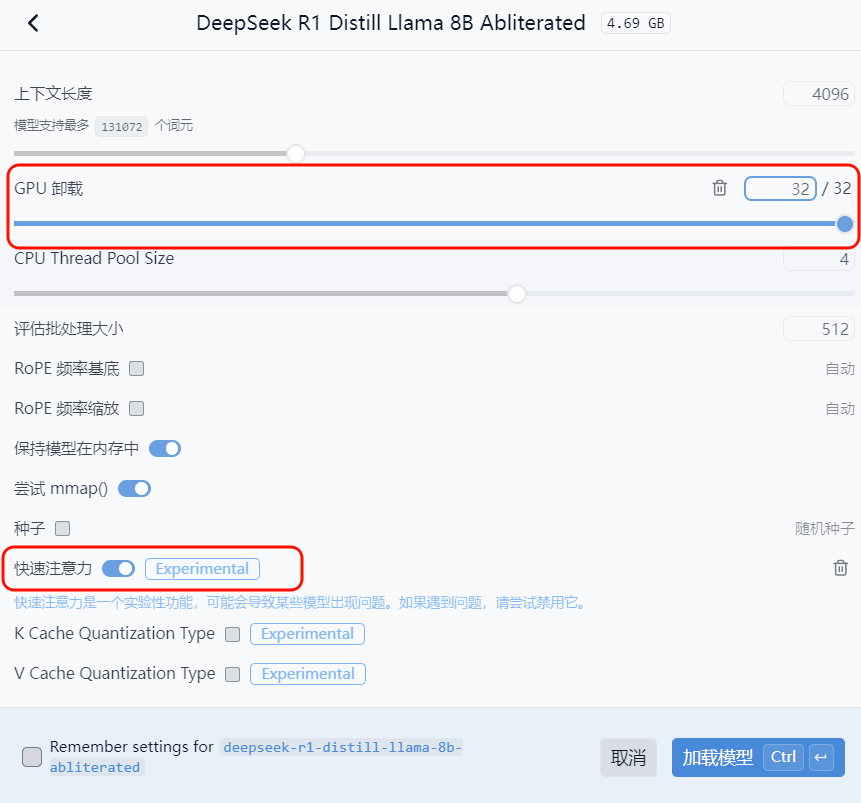

加载模型

下载完成之后点击顶部加载刚刚下载好的模型

建议拉高GPU卸载,打开快速注意力以提高性能

进行使用即可